盖世汽车讯 要在广泛的现实世界动态环境中部署,机器人必须具备成功完成各种手动任务的能力,从家务到复杂的制造或农业过程等。这些手动任务需要抓取、操纵和放置不同类型的物体,这些物体的形状、重量、属性和纹理可能会各不相同。

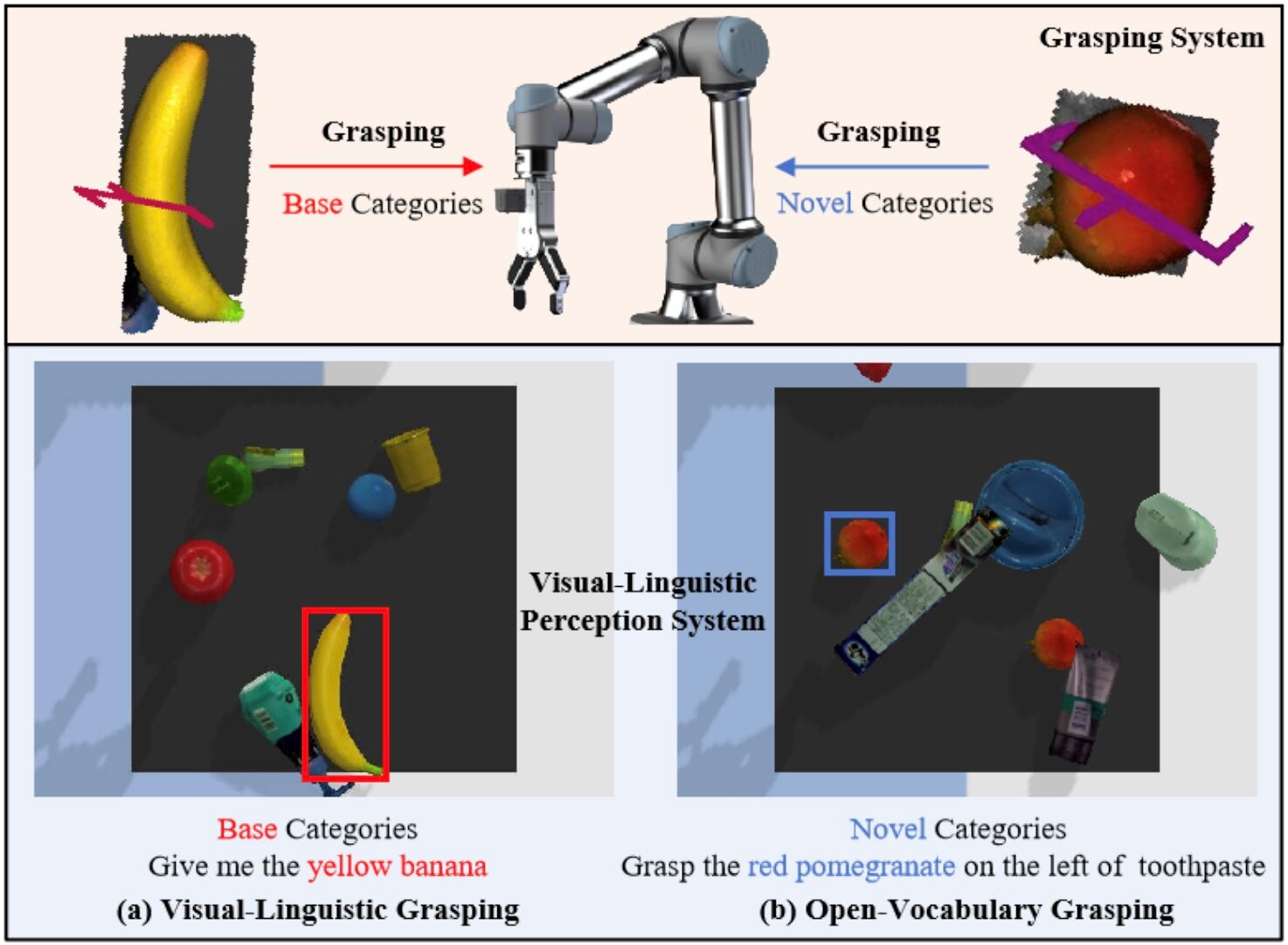

图片来源:arXiv

然而,目前大多数使机器人能够抓取和操纵物体的方法,只能使机器人与训练中遇到的物体匹配或非常相似的物体进行交互。这意味着,当机器人遇到一种新的(即以前从而见过的)物体时则无法进行抓取。

*特别声明:本文为技术类文章,禁止转载或大篇幅摘录!违规转载,法律必究。

本文地址:https://auto.gasgoo.com/news/202408/6I70401062C409.shtml

好文章,需要你的鼓励

联系邮箱:info@gasgoo.com

求职应聘:021-39197800-8035

简历投递:zhaopin@gasgoo.com

客服微信:gasgoo12 (豆豆)

新闻热线:021-39586122

商务合作:021-39586681

市场合作:021-39197800-8032

研究院项目咨询:021-39197921