寅家科技是一家全球化的高科技智能驾驶公司,多年深耕高精度传感器、深度学习算法、控制决策技术,形成智能交互、自动驾驶系统集成、特定场景自动驾驶技术领域的成熟应用。基于坚实的技术基础,寅家科技聚焦环境感知、智能决策、控制执行等领域,为客户提供安全、高效的智慧出行解决方案。

寅家科技泊车事业部首席专家张皓磊以《全场景智慧泊车方案及视觉感知的行泊一体应用优势》为主题展开演讲,以下是演讲内容整理:

寅家科技泊车事业部首席专家张皓磊

寅家科技的行泊一体技术发展之路

寅家科技成立于2013年,是集研发、生产、销售、服务于一体的自主研发高新技术企业,获得了专精特新“小巨人”企业称号,主要产品覆盖硬件、感知、算法、规控领域,提供高性能智能视觉、雷达感知硬件,领先的软件算法,以及完整的软硬件一体化解决方案、技术配套等全栈服务等,为客户提供客制化的L2-L4级智能驾驶解决方案。

寅家科技建立之初主要聚焦感知硬件和感知算法服务,一步步从环视系统到全场景泊车,最终做到行泊一体,覆盖遥控泊车、记忆泊车、代客泊车、高速道路和城市道路行车等不同场景应用。

寅家科技行泊产品的整体规划主要划分为两类,第一代行泊产品于2023年推出,是基于L2级 ADAS自动驾驶辅助系统的行泊一体和全场景泊车。第二代产品会在2024年推出,属于L4级行泊一体的产品,包含2D、3D环视全景,自动泊车功能、代客泊车、记忆泊车、影子系统、高精地图等服务,以及属于L4级别的高速公路引导 ,城市道路引导,自动上下匝道,变道超车等功能也做了对应研发部署。

目前寅家科技的自动泊车主要是向较近距离的物理车位进行泊车,采用驾驶员跟车监督的形式。但是技术演进至遥控泊车、记忆泊车以及AVP泊车之后,车位就不再局限于物理车位,而是会变成抽象的记忆存储车位,或者云端车位的模式。驾驶员的角色也会从主动监督向无监督、甚至手机操控的模式转变。行车的距离控制也会从APA泊车的3-5米,到RPA的10米以内,再到记忆泊车的1公里以内,未来演进至AVP泊车,距离还会进一步延长。可以说,伴随行泊一体技术的不断升级,泊车场景也在不断拓展。

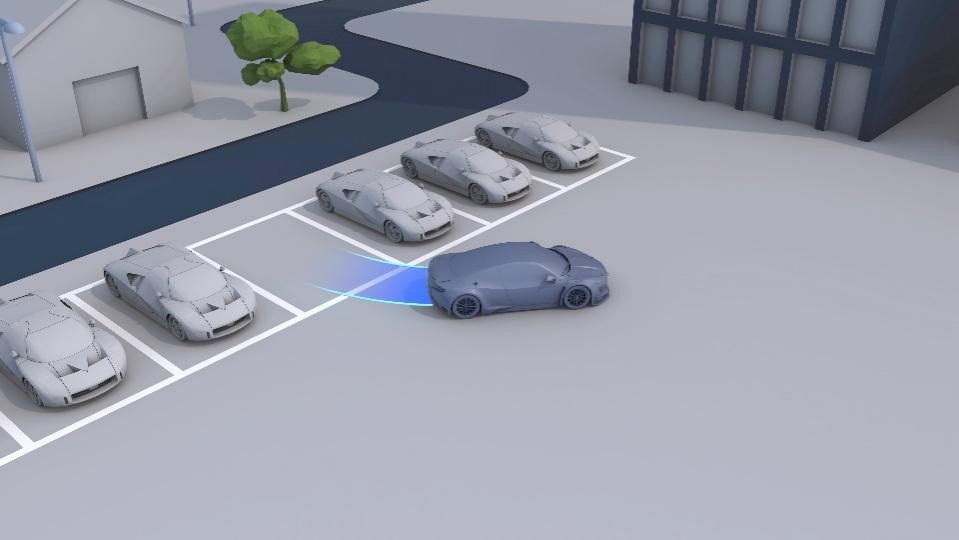

那么升级后的全场景泊车能解决什么样的痛点?首先是可以帮助到对倒车入库、侧方停车等技术不太熟练的驾驶员解决基本的停车尴尬。其次,更加一层安全保护,在泊车过程中当面临光线较暗、视野盲区有行人/动物闯入,相比初级驾驶员,自动泊车系统会有更完备的预测和处理机制。从资源利用的角度去说,人类驾驶员大多处于盲停,也就是不清楚哪里有车位,即开即停的状态,如果使用具备大数据匹配筛查能力的自动泊车,就可以一定程度上提高车位整体利用率,也可以缓解乱停乱放导致的道路拥堵。

图片来源:寅家科技

此外,在车主找车时,寅家科技会提供AR寻车功能,配套汽车周围环境的环视全景拼接图片,帮助车主更快地找到对应车辆。

寅家科技的自动泊车产品线覆盖了高中低不同等级的配置,目前性价比较高的是环视系统和超声波雷达组合,以及对于感知、定位、路径规划、车身环境的深度学习算法应用。在中高端则采用是4D毫米波雷达、激光雷达等,同时仍然在通过不断的数据闭环做算法迭代和升级,力求使用更小的算力实现更全面的功能。

寅家科技行泊一体2.0的视觉应用优势

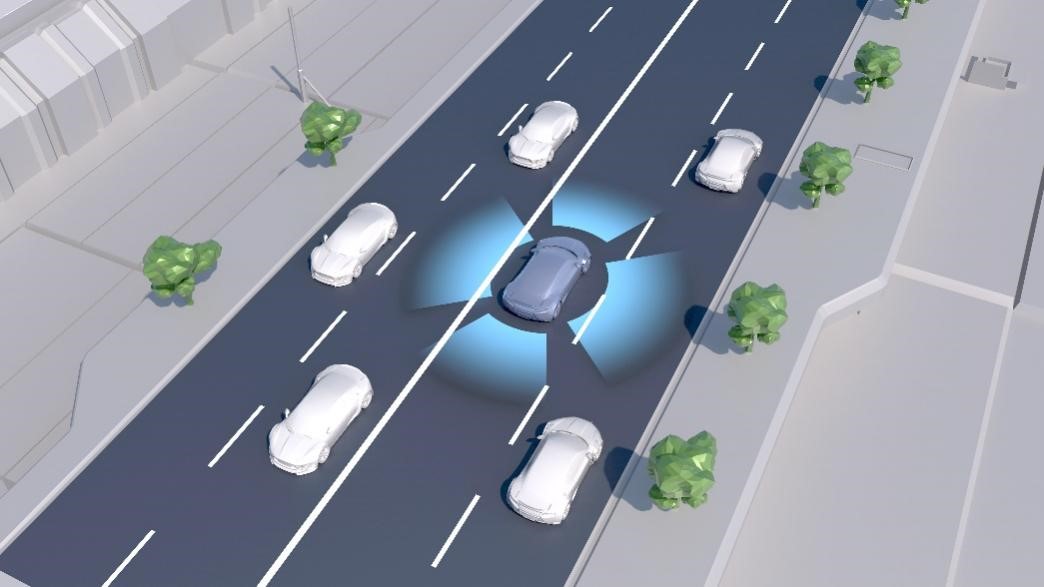

接下来是寅家科技行泊一体 2.0的视觉应用优势,行泊的整体视觉环境不再局限于四枚环视摄像头,自动驾驶前主摄像头和其他补盲摄像头也会加进“融合AVM”功能中,加强了对车身周围所有目标的感知识别、跟踪预测,更有助于高级别自动驾驶的应用。

行泊一体的整体视觉感知系统需要满足三项功能需求:第一,需要对车身周围行人、车辆,其他障碍物进行检测、标识和跟踪。第二,实现对道路环境的检测,比如车道线,车道信息,红绿灯信息、路标信息等。 第三,对可驾驶区域进行分割。第四,SLAM定位与建图。

图片来源:寅家科技

以上四项功能中,SLAM建图与车周障碍物定位有两点特别值得关注。

一是地图特征的采集与建图。驾驶员开车进入地库,在没有高精地图支持的情况下,首先需要自己手动扫图,针对这一点,寅家科技行泊一体 2.0会对地图,特别车辆行驶前向地图的可视范围内特征点进行扫描,采集车身行驶参数,如轮速、方向盘转角、IMU等综合信息,用来建立所有特征点的运动模型,利用这些数据建立特征点运动模型,在车辆行驶过程中,使用运动模型对特征点轨迹进行动态预测,获取权重更高的特征粒子构成地图要素与完整的SLAM地图。

此外,由于相似的特征点越多,地图的构建精度就越差,因此在相似度过高的情况下,系统会抓取更多特征点,以此提升整个地图的精度和锐利度,在最后则会整合所有特征点和运动轨迹,优化定位建图精度。

二是BEV感知内的空间特征融合。BEV感知与环视领域内的鸟瞰图有一定相似性,但范围更广,相比鸟瞰视图还囊括了汽车行驶前向视角主摄像头的领域,会整合感知区域、车身原点坐标、时间轴进行一个4D虚拟化的时空同步输出。

目前,寅家科技行泊一体 2.0主要是用Transform做BEV图像的输出投影,未来还会融合激光雷达、毫米波雷达、点云等多维度的感知信息,进一步提高自动驾驶环境感知的一致性、安全性和即时性。

(以上内容来自上海寅家电子科技股份有限公司泊车事业部首席专家张皓磊于2022年9月15日由盖世汽车主办的2022第五届自动驾驶与人机共驾论坛发表的《全场景智慧泊车方案及视觉感知的行泊一体应用优势》主题演讲。)

本文地址:https://auto.gasgoo.com/news/202209/26I70315409C103.shtml

好文章,需要你的鼓励

联系邮箱:info@gasgoo.com

求职应聘:021-39197800-8035

简历投递:zhaopin@gasgoo.com

客服微信:gasgoo12 (豆豆)

新闻热线:021-39586122

商务合作:021-39586681

市场合作:021-39197800-8032

研究院项目咨询:021-39197921