盖世汽车讯 随着深度学习技术的发展,提高算法的鲁棒性变得至关重要。在执行诸如自动驾驶、欺骗检测和面部识别等安全关键任务时,对抗性样本攻击一直都是一大挑战。通常,此种对抗性输入肉眼无法察觉,却可以对AI系统构成威胁,或导致系统出错。例如,自动驾驶汽车被入侵,可能导致车速提高,或者被路牌上粘贴的贴纸误导,而驶入错误的车道。

(图片来源:analyticsindiamag.com)

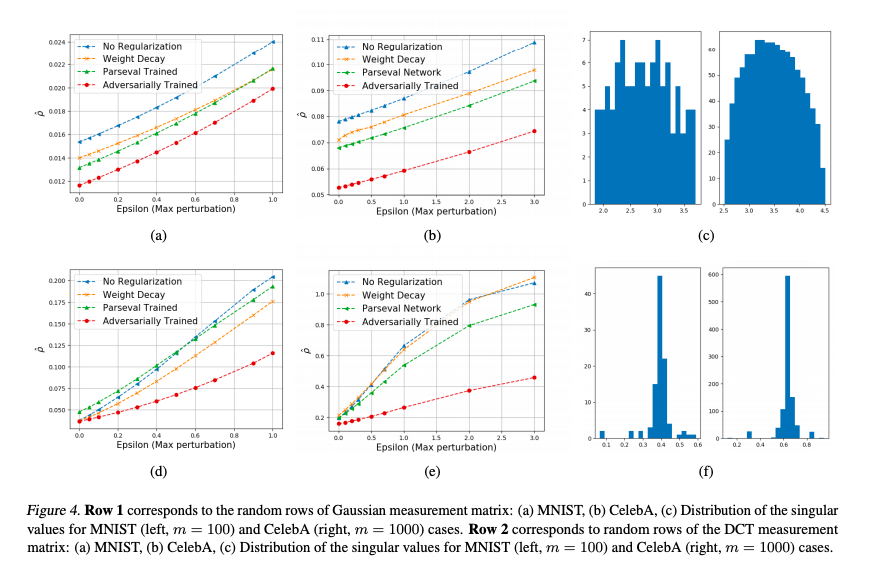

据外媒报道,伊利诺伊大学香槟分校(University of Illinois at Urbana-Champaign)的研究人员提出了一种新方法来训练端到端基于深度学习的对抗问题解决模型,旨在了解对抗性攻击(adversarial attacks)对于测量空间而非信号空间的影响。

*特别声明:本文为技术类文章,禁止转载或大篇幅摘录!违规转载,法律必究。

本文地址:https://auto.gasgoo.com/news/202007/15I70196774LC409.shtml

好文章,需要你的鼓励

联系邮箱:info@gasgoo.com

求职应聘:021-39197800-8035

简历投递:zhaopin@gasgoo.com

客服微信:gasgoo12 (豆豆)

新闻热线:021-39586122

商务合作:021-39586681

市场合作:021-39197800-8032

研究院项目咨询:021-39197921