盖世汽车讯 据外媒报道,随着自动驾驶车辆的引入,负责车辆决策人工智能的研发人员们不得不面临有些尴尬的道德难题,例如:车辆在发生碰撞事故时,应该保护驾驶员还是道路上的行人?

有一篇文件在《自然》(Nature)上发布:该篇文章详细谈及了“道德机器(The Moral Machine)”的实验结果,该实验吸引了近200万名参与者,先假设自动驾驶车辆与行人发生碰撞事故,再由上述参与者在乘客及行人的生命之间作出抉择,采集其对这类道德难题情境下所做的选择。

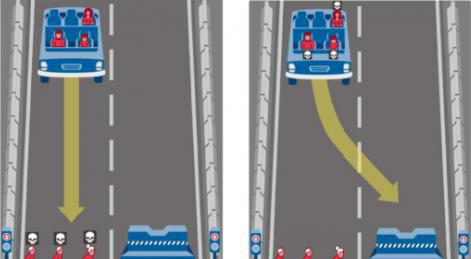

举个例子,实验参与者将获得相关图示,假设车辆的制动发生故障,他(她)需要在以下两种选项中作出选择:“三名老年人因乱穿马路并遭遇事故而丧命”或“车内的年轻人及其家人因车祸丧命。”

此外,还包括以下“二选一”的难题:

人类VS宠物

保持正确的行驶方向VS转向

乘客VS行人

多数人的性命VS少数人的性命

男人VS女人

年轻人VS老年人

遵守法规的行人VS乱穿马路的人

健康的人VS不太健康的人

社会地位较高的人VS社会地位较低的人

从获得的各类回复看,不论参与该实验的人群来自哪个国家或哪个地域,其回答都具有以下偏向性:选择保障人类的生命而牺牲宠物、选择挽救更多人的性命而牺牲少数人、选择拯救年轻人而牺牲老人。

尽管实验的结果显而易见,但若要将该类选择偏好融入到自动驾驶系统的软件中,似乎不太容易。对自动驾驶系统而言,探查动物要比探查人类简单,判定生命的价值也相对较为简单,但若基于年龄、性别、社会地位等属性来判断各类人群的生命价值,这就变得十分复杂。

例如:若将人工智能对人群的偏向性选择进行如下设置:优先保护儿童而牺牲老年人、优先保护成年人而牺牲老年人,研究人员需要对各人群的年龄范围(age brackets)进行明确的边界限定,基于全球角度而言,想要取得统一的界定标准,这件事本身的操作难度就很大,更遑论基于该范围作出决策算法的设定了。(本文图片选自techradar.com)

*特别声明:本文为技术类文章,禁止转载或大篇幅摘录!违规转载,法律必究。

本文地址:https://auto.gasgoo.com/News/2018/10/310611361136I70070204C601.shtml

好文章,需要你的鼓励

联系邮箱:info@gasgoo.com

求职应聘:021-39197800-8035

简历投递:zhaopin@gasgoo.com

客服微信:gasgoo12 (豆豆)

新闻热线:021-39586122

商务合作:021-39586681

市场合作:021-39197800-8032

研究院项目咨询:021-39197921