盖世汽车讯 基础模型是大规模深度学习模型,已在大量通用、未标记的数据上进行了预训练,可应用于各种任务,例如生成图像或回答客户问题。这些模型是ChatGPT和DALL-E等人工智能工具的支柱,但它们可能会提供错误或误导性的信息,在安全攸关的情况下(例如行人接近自动驾驶汽车)这些错误信息可能造成严重后果。

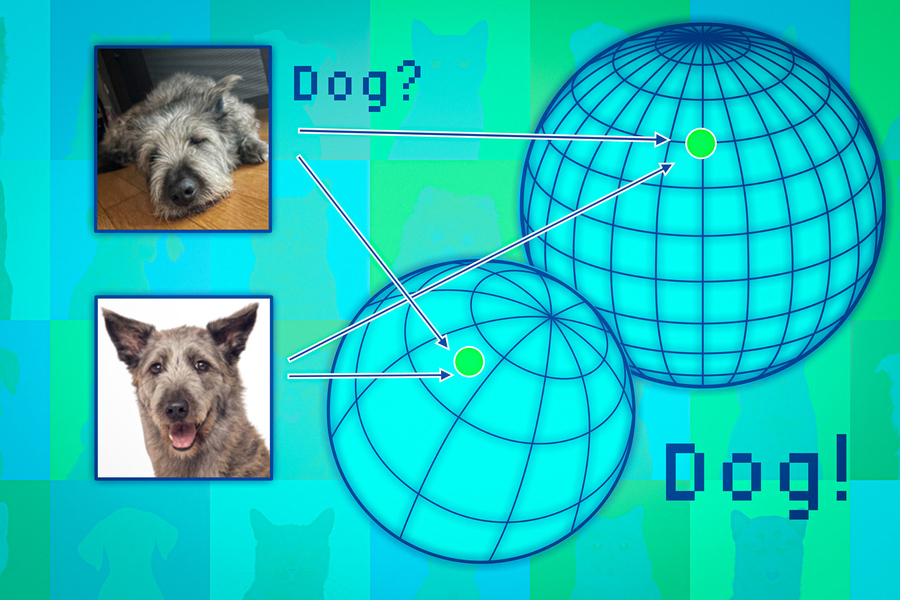

(图片来源:麻省理工学院)

据外媒报道,为了帮助防止出现此类错误,麻省理工学院(MIT)和MIT-IBM沃森人工智能实验室(MIT-IBM Watson AI Lab)的研究人员开发出一种技术,可以在将基础模型部署到特定任务之前评估其可靠性。

研究人员考虑通过一组彼此略有不同的基础模型来实现这一目标,然后利用其算法来评估每个模型学习到的关于同一测试数据点的表示(representation)的一致性。如果这些表示一致,则意味着模型可靠。

与最先进的基线方法相比,这种技术能够更好地体现在各种下游分类任务中基础模型的可靠性。人们可以利用这种技术来决定是否可以在特定环境中应用模型,而无需在真实数据集上进行测试。当数据集可能因隐私问题而无法访问时(例如在医疗保健环境中),这可能特别有用。此外,该技术还可用于根据可靠性评分对模型进行排名,从而使用户能够为其任务选择最佳模型。

研究人员Navid Azizan表示:“所有模型都可能出错,但知道自己什么时候出错的模型更有用。对于这些基础模型来说,量化不确定性或可靠性的问题更具挑战性,因为它们的抽象表示难以进行比较。这种方法允许人们量化表示模型(representation model)对于各种给定输入数据的可靠性。”

*特别声明:本文为技术类文章,禁止转载或大篇幅摘录!违规转载,法律必究。

本文地址:https://auto.gasgoo.com/news/202407/19I70399464C601.shtml

好文章,需要你的鼓励

联系邮箱:info@gasgoo.com

求职应聘:021-39197800-8035

简历投递:zhaopin@gasgoo.com

客服微信:gasgoo12 (豆豆)

新闻热线:021-39586122

商务合作:021-39586681

市场合作:021-39197800-8032

研究院项目咨询:021-39197921