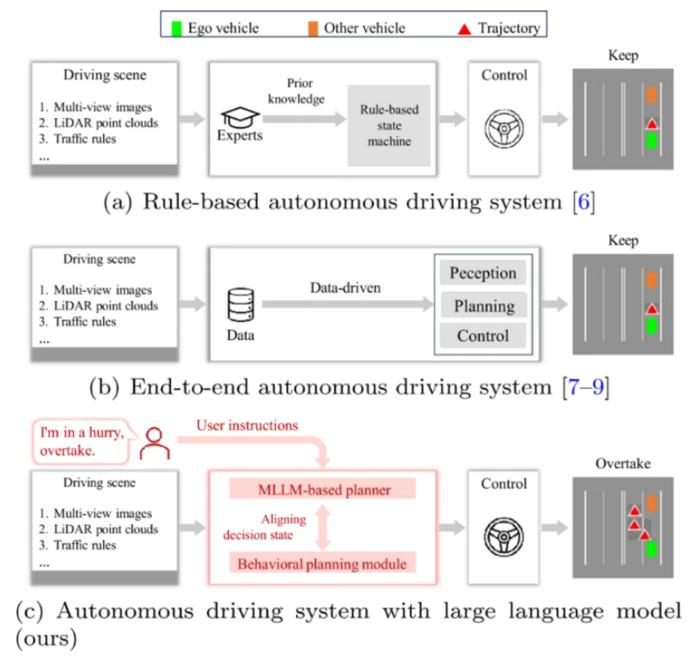

盖世汽车讯 自动驾驶技术发展迅速,已从基于规则的系统发展到深度神经网络。然而,端到端模型仍然存在一些重大缺陷:它们通常缺乏对世界的认知,在罕见或模糊的场景下表现不佳,并且对其决策过程的解释能力有限。相比之下,大语言模型(LLM)擅长推理、理解上下文和解释复杂的指令。但是,LLM的输出是语言形式而非可执行指令,这使得将其与实际车辆控制系统集成变得困难。这些不足之处凸显了对一种框架的需求,该框架能够将多模态感知与基于既定驾驶逻辑的结构化、可执行的决策输出相结合。解决这些挑战需要深入研究如何将多模态推理与自动驾驶规划器相结合。

图片来源: 期刊《Visual Intelligence》

据外媒报道,上海交通大学、上海人工智能实验室、清华大学及合作机构的研究团队开发了一种用于闭环自动驾驶的多模态大型语言模型框架DriveMLM。相关研究成果已发表在期刊《Visual Intelligence》上(DOI: 10.1007/s44267-025-00095-w)。

DriveMLM集成了多视角摄像头图像、激光雷达点云、系统消息和用户指令,生成对齐的行为规划状态。这些状态可以直接输入到现有的运动规划模块,从而实现实时驾驶控制,同时生成对每个决策的自然语言解释。

*特别声明:本文为技术类文章,禁止转载或大篇幅摘录!违规转载,法律必究。

本文地址:https://auto.gasgoo.com/news/202512/12I70438862C409.shtml

联系邮箱:info@gasgoo.com

求职应聘:021-39197800-8035

简历投递:zhaopin@gasgoo.com

客服微信:gasgoo12 (豆豆)

新闻热线:021-39586122

商务合作:021-39586681

市场合作:021-39197800-8032

研究院项目咨询:021-39197921